2023-Q3-AI 5. Image classification - ConvNet ResNet

5.1. Video / Materials

Video: https://youtube.com/live/nVY2l0CWN6Y?feature=share

Jamboard: https://jamboard.google.com/d/1Hwx0VZ7OKecyJnUps0d-CZXKiR5vFPTsg4Fe7-DMgEA/edit?usp=sharing

Materials: https://cs231n.github.io/convolutional-networks/ http://www.cs.utoronto.ca/~rgrosse/cacm2011-cdbn.pdf https://ikhlestov.github.io/pages/machine-learning/convolutions-types/ https://github.com/vdumoulin/conv_arithmetic/blob/master/README.md

ResNet: https://arxiv.org/abs/1512.03385

DenseNet: https://arxiv.org/abs/1608.06993

Ir iedota pieeja jamboard un ar OBS jāveic screen streaming uz šādu setting

OBS key: s29p-6tk6-hyq3-uueu-0hvf

Par katru uzdevumu dodam 100 punktus

5.2. Implement the Conv2D kernel function

Implement Conv2D without using the built-in PyTorch version, following the instructions from the video.

Submit the code and a screenshot with the best results.

Template:

http://share.yellowrobot.xyz/quick/2023-2-27-7FA5DF91-9B41-4E56-8630-485CCA078E45.zip

5.3. Implement ResBlock according to the scheme

Implement ResBlock according to the scheme, this time using the built-in PyTorch ConvNet2d class.

Submit the code and a screenshot with the best results.

Template:

http://share.yellowrobot.xyz/quick/2023-3-5-746B40C5-AD38-4ABC-B0EB-88664531AC55.zip

Scheme:

http://share.yellowrobot.xyz/upic/a65c781c39c912ce3f6eb0fa0d8683d2_1648487642.png

5.4. Implement DenseBlock according to the scheme

Implement DenseBlock according to the scheme:

http://share.yellowrobot.xyz/upic/78a04509453a172cc8e9f4596e3f1bfb_1648487642.png

Concat torch across the channel dimension: out = torch.cat([x, conv1, conv2], dim=1)

Submit the code and a screenshot with the best results.

5.5. Implement Transition Layer according to the scheme

Implement Transition Layer according to the scheme:

http://share.yellowrobot.xyz/upic/818ebd4aefaaac1b89a95a001b8c2f84_1648487642.png

Submit the code and a screenshot with the best results.

Klases materiāli

Vēl labi materiāli + vizuālizācijas:

https://ikhlestov.github.io/pages/machine-learning/convolutions-types/

https://github.com/vdumoulin/conv_arithmetic/blob/master/README.md

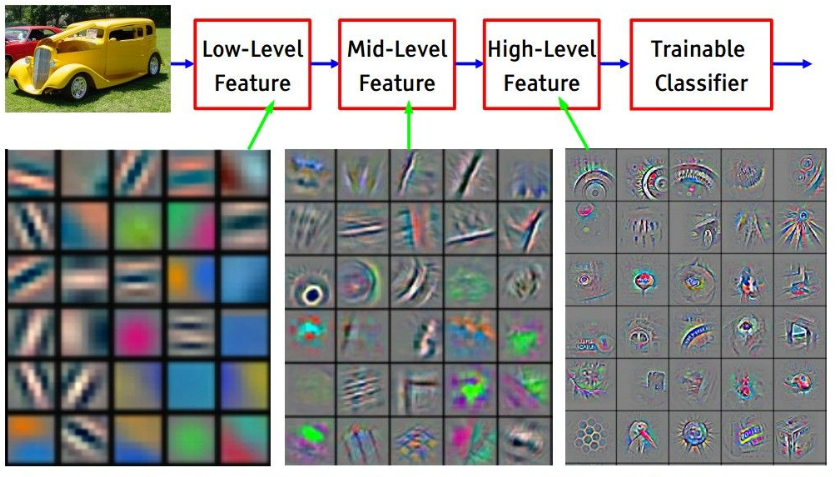

Saturs - ConvNet:

Sākotnēji resursu dēļ izmantoja convnets kā optimizāciju parametru skaitam - Le Cun

Izstāstīt basics datu struktūru image classification task (viņi zina tikai regresiju un klasifikāciju parastiem 1D datiem)

Izstāstīt un implementēt Conv2D kernel function kopā

Ja paspēj var klasē iedot implementēt BatchNorm + izstādīt dažādus norm un pooling

Mājās implementēt ar iebūtvētajām torch functions arhitektūru

Ideāli būtu pamēģināt citu dataset nevis FashionMNIST, piemēram, bet tad jāsagatavo ar download_url_to_file kā 6. sessijā GIT piemērā

Fruits - https://www.kaggle.com/moltean/fruits

100x100

Fish - https://www.kaggle.com/crowww/a-large-scale-fish-dataset

Flowers - https://www.kaggle.com/alxmamaev/flowers-recognition

Olivetti faces - sklearn (1, 64, 64), 40 classes - test 100%

Iepriekšējā gada video par ConvNet

Video: https://youtu.be/xaj1cWtI_BM

Jamboard: https://jamboard.google.com/d/152zSE59rHNV9m-aMhhckM174RiHKdi1RQy_-XSrBN38/edit?usp=sharing

Iepriekšējā gada video par ResNet

Video: https://youtu.be/y9CcSpH1Db4

Jamboard (iedota edit pieeja stefan.dayneko@gmail.com): https://jamboard.google.com/d/1T0k_rnWjj5Flyd0BzJ3-At0QyOth78lfTSkKMdS1Zck/edit?usp=sharing

Saturs - ResNet:

Wanishing gradient problem, training time

Jāizstāsta par ResNet jēgu

Kopīgi jāuzkodē

Jāpastāsta vairāk kā izmantot cuda un kā palaist uz GoogleCollab, jo o aizmirsam pagājušā reizē laikam

pastāstīt par print_model_size

Jāizstāsta par DenseNet jēgu

Kopīgi jāuzkodē

Parādīt kā pārveidot dataset un CCE loss, lai strādātu ar indexes bez One-hot-encoded

Mājās InceptionNet jāiedod - 1000 punkti

⚠️ Iesaku parādīt / pamainīt saturu, lai implementētuj HRNet, RegNet

https://paperswithcode.com/method/hrnet

⚠️ Lūdzu neizmantot __call__ operatoru

xxxxxxxxxx11out = self.conv1(x)Tā vietā izmantot

xxxxxxxxxx11out = self.conv1.forward(x)Citādi studenti nesaprot atsķirību starp member funkciju un member instances funkcijas izsaukumu

⚠️ Lūdzu neraksti objektus / funkcijas bez named params, ja ir hardcoded

xxxxxxxxxx11self.linear = torch.nn.Linear(288, 10)vietā

xxxxxxxxxx11self.linear = torch.nn.Linear(in_features=288, out_features=10)

Jo, tad kods nav saprotams tiem, kas nepārvalda ļoti labi tās funkcijas

Bildes slaidiem

https://www.cs.umd.edu/~tomg/projects/landscapes/

Bioloģiskais pamatojums, bet patiesība optimizācija

http://cs231n.stanford.edu/slides/2018/cs231n_2018_lecture05.pdf

ResNet / DenseNet